PREMIER

PREMIER

Онлайн-кинотеатр PREMIER – это стриминговый видеосервис фильмов и сериалов, а также развлекательных и спортивных телевизионных программ. Фокус кинотеатра – качественные российские сериалы и кино разных жанров для всей семьи. Команда PREMIER основательно подходит к маркетинговой стратегии и предпочитает планировать активности, основываясь не только на внутренней аналитике, но и данных пользовательского шлейфа. Мнения, вкусы, предпочтения пользователей – вот что действительно важно учитывать в коммуникации с аудиторией.

PREMIER обратились к “Энергии” с брифом на Social Listening исследование рынка онлайн-киносмотрения за 2023 год: анализ аудитории, платформ и контента. Объем данных был внушительным — 10 млн упоминаний из 5400 источников и 30+ объектов мониторинга. Требовалось обеспечить чистоту данных и создать reusable dataset для дальнейшего использования.

ЦЕЛЬ

- Провести SL-исследование для онлайн-кинотеатра PREMIER

ЗАДАЧИ

- Собрать 10 млн упоминаний бренда из открытых источников в интернете

- Обработать упоминания

- Подготовить полный и понятный датасет, который можно будет использовать для планирования маркетинговых коммуникаций

ВЫЗОВЫ

- Сверхмассивность данных, которые необходимо обработать.

- Сверхразнородность данных: дубли, нерелевантные упоминания, ошибки.

- Необходимость фильтрации каждого упоминания из ~10 млн по 176 тегам.

- Ограниченные сроки и большой масштаб задачи.

Стандартное Social Listening исследование не справилось бы с таким объемом, ведь даже на разметку данных вручную потребовалось бы 100 асессоров и три месяца работы. Мы решились на челлендж – привлечь к исследованию искусственный интеллект и разработать на его основе инструмент, который бы справился с задачей не хуже человека, но сэкономил нам человеческие и временные ресурсы.

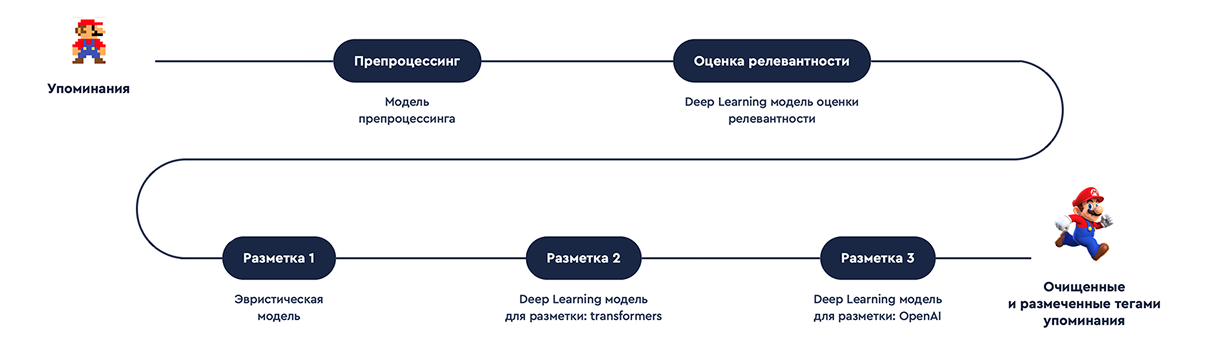

Задача непростая. Сначала мы создали пайплайн – многоэтапный процесс обработки информации.

Разработанный пайплайн включал в себя несколько ключевых этапов:

1. Очистка данных от информационного мусора

2. Определение релевантности

3. Тегирование

Мы собрали 10 млн упоминаний с помощью систем мониторинга, а затем приступили к работе с искусственным интеллектом.

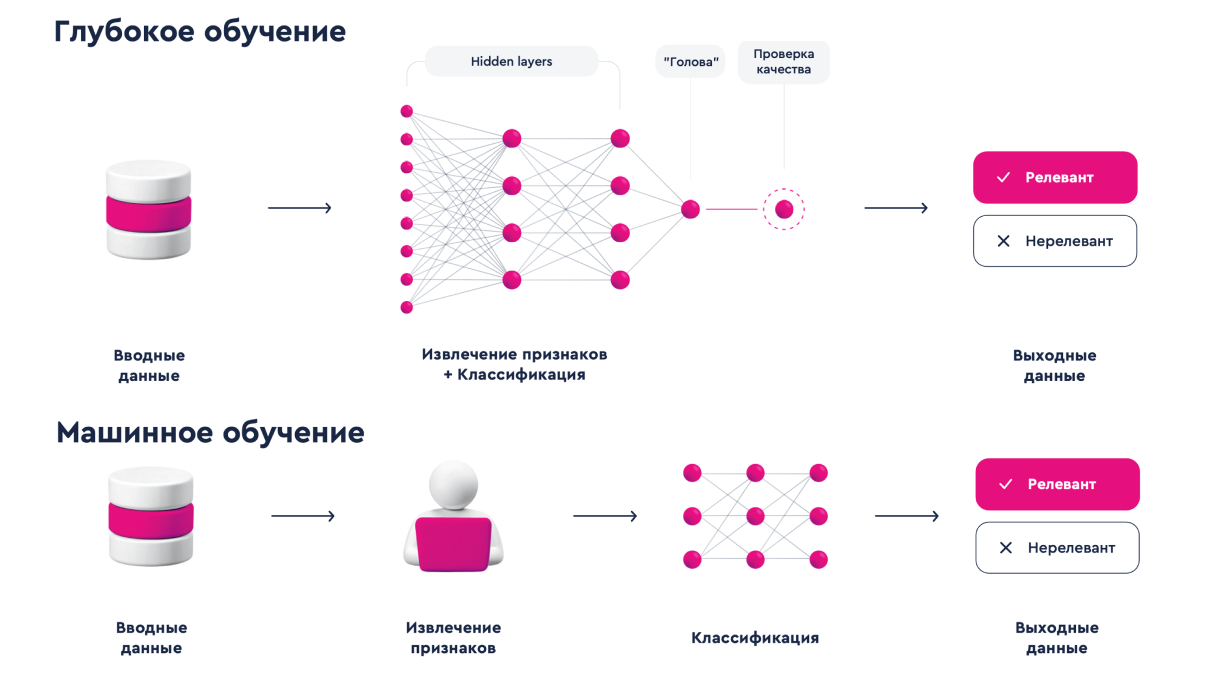

Мы разработали две AI-модели:

— первая была создана на основе машинного обучения, она очищала и препроцессировала данные, фильтровала релевантные тексты и автоматически размечала теги, однако оказалась не так эффективна в работе со сложными и редкочастотными упоминаниями.

— вторая была на основе глубокого обучения. Особенность такой модели в том, что она работает со слоями данных и может самообучаться. Разные типы тегов размечались разными элементами модели: эвристической моделью, DL OpenSource, OpenAI 3.5. Это помогло решить вопрос обработки редкочастотных упоминаний и добиться точности человека – 95%.

В результате мы получили объемный датасет, содержащий классифицированные данные о предпочтениях, вкусах и потребностях аудитории. Однако для на поиск нужных выводов в большом датасете уходило много времени, что было неудобно, и мы обратились к команде PREMIER с новой необычной идеей – создать AI-бот, который бы выполнял поиск этих выводов за маркетологов. AI-бот с функцией аналитика способен за секунды найти в отчете по исследованию нужные инсайты и предложить идеи для контента.

НАГРАДЫ

Tagline Awards 2024 — шортлист

Хрустальный Шар 2024 – серебро

Результаты

-

1

SL-исследование с сверхмассивными данными;

-

2

кастомных AI-инструмента для работы с данными;

-

5

чек-листов для регулярного чек-апа командой;

-

95%

качества определения мусора, с помощью AI-модели;

-

85%

качества разметки, с помощью AI-модели;

-

100%

неограниченный объем обработки упоминаний, с помощью AI-модели;